Microsoft ha anunciado el lanzamiento de Mu, un modelo de lenguaje pequeño específicamente diseñado para ejecutarse de forma local en dispositivos con Unidad de Procesamiento Neuronal (NPU).

Este desarrollo se enmarca en la estrategia de la compañía de impulsar la inteligencia artificial en el entorno local, optimizando el rendimiento y reduciendo la dependencia de la nube. Mu ya se encuentra integrado en el agente de Configuración de Windows 11, disponible para los usuarios del programa Windows Insider en dispositivos Copilot+.

Mu está desarrollado para abordar tareas que requieren inferencia de relaciones complejas entre entradas y salidas

Mu está desarrollado para abordar tareas que requieren inferencia de relaciones complejas entre entradas y salidas. Su arquitectura encoder-decoder, basada en transformadores, convierte las entradas de texto en una representación latente sobre la que genera las respuestas. Esta estructura permite separar el procesamiento de entrada del de salida, lo que reduce la carga de cómputo y memoria, aspectos críticos para dispositivos con recursos limitados.

El modelo se descarga por completo en la NPU del dispositivo, lo que le permite alcanzar velocidades superiores a 100 tokens por segundo y ofrecer latencias inferiores a los 500 milisegundos, de acuerdo con Microsoft. Estas cifras cumplen los requisitos de experiencia de usuario necesarios para el agente de Configuración de Windows, que debe ser capaz de ofrecer respuestas rápidas y contextualmente adecuadas en tareas del sistema operativo.

Un modelo pequeño con capacidades avanzadas

Con 330 millones de parámetros, Mu mantiene una relación de eficiencia notable. Según Microsoft, su rendimiento es comparable al de Phi-3.5-mini, un modelo diez veces más grande. Esto se consigue gracias a técnicas como la normalización dual (Dual LayerNorm), el uso de Rotary Positional Embeddings (RoPE) para el manejo de contextos largos, y la atención agrupada (Grouped-Query Attention, GQA), que reduce el uso de memoria sin sacrificar precisión.

Mu está entrenado con millones de tokens educativos, orientados a comprender la gramática, sintaxis, semántica y conocimiento general del lenguaje

Mu se ha entrenado inicialmente con cientos de miles de millones de tokens educativos, orientados a comprender la gramática, sintaxis, semántica y conocimiento general del lenguaje. Posteriormente, se aplicó destilación desde modelos Phi, técnica que transfiere conocimiento desde un modelo mayor a otro más pequeño, permitiendo preservar precisión con menos parámetros.

El diseño de Mu se ha adaptado a las características de las NPUs utilizadas en los portátiles Copilot+, en colaboración con socios de silicio como AMD, Intel y Qualcomm. Entre las optimizaciones se encuentra la cuantificación post-entrenamiento (PTQ), que convierte los pesos y activaciones del modelo a formatos enteros (8 y 16 bits), lo que reduce el uso de memoria sin necesidad de reentrenamiento.

Este enfoque permite que Mu alcance un rendimiento superior a 200 tokens por segundo en dispositivos como el Surface Laptop 7, según datos de Microsoft. Además, la distribución de parámetros entre codificador y decodificador se ha ajustado (aproximadamente 2/3 frente a 1/3) para maximizar la eficiencia en las operaciones de la NPU.

Aplicación concreta en el agente de Configuración

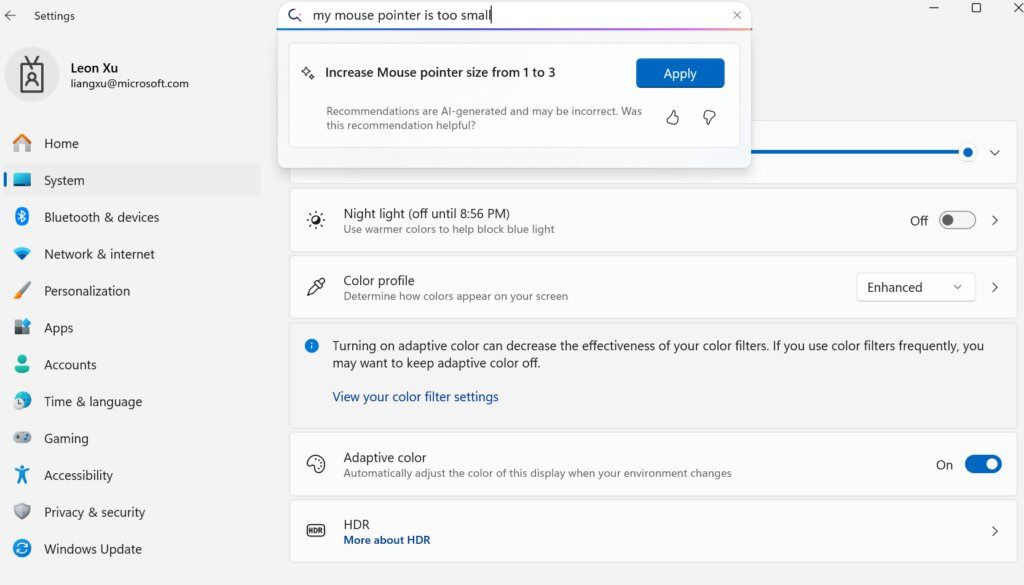

El primer caso de uso de Mu es el agente de Configuración de Windows 11. Esta herramienta permite a los usuarios interactuar con los ajustes del sistema mediante lenguaje natural. A través del procesamiento local, el modelo interpreta consultas como “activar Bluetooth” o “aumentar el brillo” y las convierte en llamadas directas a funciones del sistema.

La integración en la interfaz de búsqueda del sistema permite diferenciar entre consultas vagas y aquellas con intención clara. En el primer caso, se ofrecen resultados semánticos; en el segundo, el agente actúa directamente. Para alcanzar este nivel de precisión, Microsoft ha ampliado el entrenamiento de Mu con 3,6 millones de muestras y ha afinado su capacidad para gestionar cientos de configuraciones distintas.

Uno de los principales retos ha sido resolver ambigüedades frecuentes en las órdenes del usuario, como aquellas que afectan a múltiples dispositivos o configuraciones superpuestas. Microsoft ha ajustado sus datos de entrenamiento para priorizar las configuraciones más utilizadas y garantizar una experiencia precisa en escenarios comunes.