Huawei ha aprovechado su conferencia anual en Shanghái para detallar, por primera vez, un plan a varios años que busca sostener la demanda de cómputo de inteligencia artificial en China sin depender de Nvidia.

La estrategia combina nueva infraestructura de interconexión para mega-clústeres, dos generaciones de SuperPoDs Atlas, una familia renovada de chips Ascend y servicios de nube orientados a computación de IA bajo demanda.

SuperPoD Interconnect y UnifiedBus: la base del escalado

La pieza nuclear del plan es el nuevo SuperPoD Interconnect, una tecnología de enlace que permite agrupar hasta 15.000 aceleradores, incluidos los Ascend, en una única “máquina lógica”. El objetivo es replicar a escala el principio de NVLink de Nvidia: más ancho de banda entre chips para entrenar modelos cada vez mayores. “La potencia informática es, y seguirá siendo, clave para la IA. Esto es especialmente cierto en China”, ha destacado Eric Xu, presidente rotatorio de Huawei, al presentar UnifiedBus, su protocolo de interconexión para SuperPoDs, y su especificación UnifiedBus 2.0 para fomentar un ecosistema abierto.

Huawei sostiene que el cuello de botella actual no está solo en la potencia del chip individual, sino en la capacidad de enlazar miles de procesadores, SuperPoDs y, después, SuperClusters a larga distancia manteniendo baja latencia y alta fiabilidad. De ahí la publicación de especificaciones y la invitación a socios para desarrollar componentes compatibles.

Atlas 950 y Atlas 960: calendario y cifras de potencia

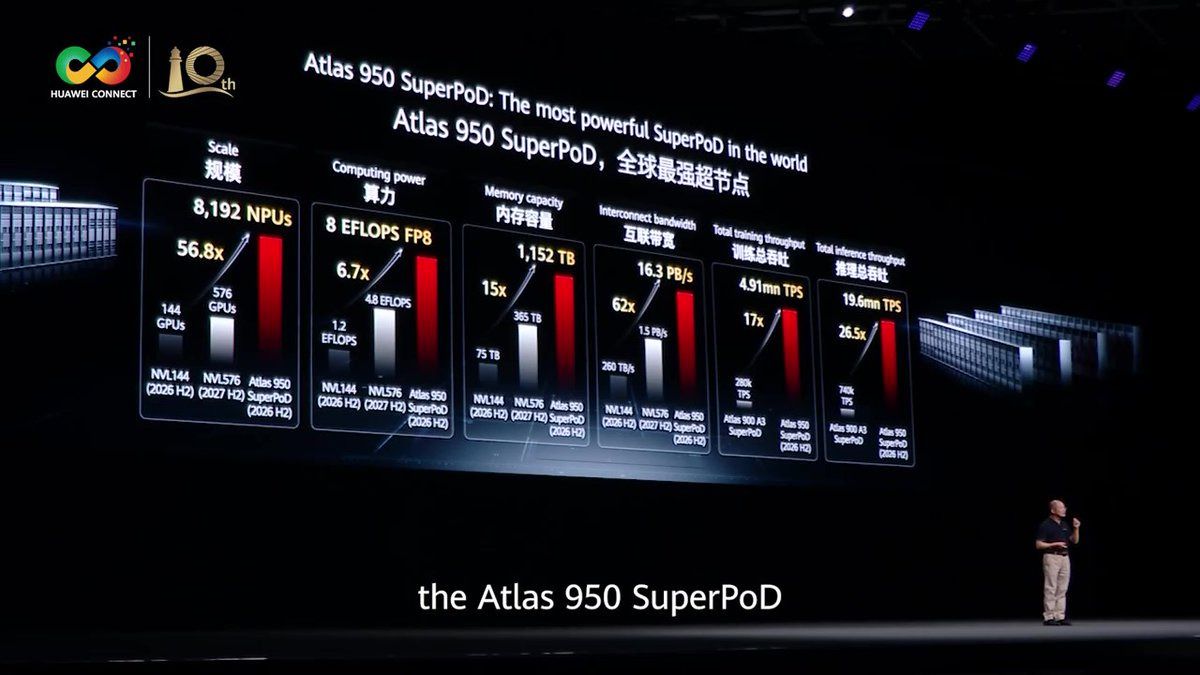

En el terreno de producto, Huawei ha anunciado el Atlas 950 SuperPoD para el cuarto trimestre de 2026 con soporte para más de 8.000 NPUs Ascend, 128 racks de cómputo y unos 1.000 m² de superficie. El sistema alcanzará 6,7 veces más potencia de cómputo y 15 veces más capacidad de memoria que la generación previa, hasta 1.152 TB, en palabras de Xu.

Un año más tarde, en el cuarto trimestre de 2027, llegará el Atlas 960 SuperPoD, con hasta 15.488 Ascend 960, 30 exaflops de potencia y 4.460 TB de memoria. Huawei afirma que ambos “liderarán el mundo en métricas clave” y que se mantendrán como supernodos de referencia “durante años”, un posicionamiento que aspira a ocupar el espacio que dejan los últimos vetos a Nvidia en el mercado chino.

La ambición va más allá del nodo individual: la compañía ha avanzado los Atlas 950/960 SuperCluster, que agregan múltiples SuperPoDs en clústeres de más de 500.000 y de más de un millón de NPUs Ascend, respectivamente. En paralelo, ha presentado TaiShan 950 SuperPoD, una aproximación de cómputo general que, combinada con GaussDB distribuida, se plantea como alternativa a mainframes y a soluciones de base de datos de gama alta.

Chips Ascend: tres años, cuatro familias

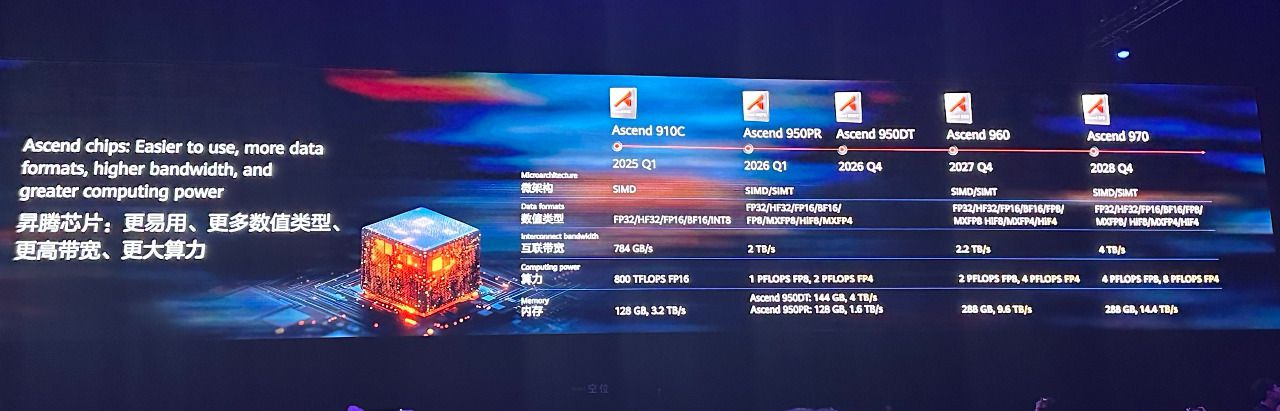

Huawei también ha desvelado un calendario de silicio que encadena cuatro líneas de Ascend durante los próximos tres años: 950PR, 950DT, 960 y 970. La serie 950 inaugura la etapa con dos piezas diferenciadas. El Ascend 950PR, optimizado para la fase de prefill de inferencia y para recomendación, se lanzará en el primer trimestre de 2026 en dos formatos. El 950DT, con banda de interconexión de hasta 2 Tb/s, llegará en el cuarto trimestre de 2026 para mejorar entrenamiento, capacidad y ancho de banda de memoria.

“Necesitamos reunir chips menos avanzados y convertirlos en un superpod, que pueda funcionar como un solo ordenador”

La familia Ascend 960 duplicará cómputo, ancho y capacidad de memoria respecto a su predecesor y estará disponible en el cuarto trimestre de 2027. Después tomará el relevo la serie 970. El mensaje de Xu ha sido explícito sobre la filosofía de diseño: “Necesitamos reunir chips menos avanzados y convertirlos en un superpod, que pueda funcionar como un solo ordenador”.

El directivo ha recordado las restricciones de fabricación avanzada por sanciones y ha sintetizado el enfoque en conectividad, asegurando que “incluso sin TSMC y enfrentándonos a una prohibición de EE. UU., hemos invertido mucho en tecnología de conectividad y hemos logrado avances, lo que nos ha permitido conseguir supernodos con decenas de miles de tarjetas”.

El anuncio llega un día después de que reguladores chinos ordenaran a actores locales dejar de adquirir hardware de Nvidia, incluidos servidores específicos para ese mercado. Huawei admite que, “a nivel de chip”, cada acelerador Ascend no iguala a un Nvidia de última generación; la apuesta es ganar por agregación a nivel de superpod: más tarjetas, mejor enlace y orquestación para ofrecer el mayor rendimiento de sistema disponible en China.

Nube de IA: consumo como servicio y modelos fundacionales

El plan se completa desde Huawei Cloud. Zhang Ping’an, CEO de la unidad, ha presentado AI Token Service sobre el supernodo CloudMatrix384, que “convierte tareas en serie en tareas paralelas distribuidas” y, según la compañía, ofrece “un rendimiento de inferencia medio por tarjeta que es de 3 a 4 veces superior al de H20” en escenarios online, nearline y offline. La propuesta abstrae la complejidad de hardware y expone resultados de cómputo de IA como servicio, una vía clave para empresas que necesitan inferencia a escala sin operar su propia infraestructura.

Huawei Cloud reforzará además su inversión en Pangu Models, con despliegues ya citados en más de 500 escenarios y 30 industrias, y mantendrá su posicionamiento de “una infraestructura global en la nube y dos motores: uno con datos y otro con IA”, en palabras de Charles Yang, vicepresidente sénior de Huawei, para acompañar a clientes en su transición digital e inteligente.

La hoja de ruta de Huawei encaja con un objetivo político-industrial: asegurar oferta local de cómputo de IA con procesos de fabricación disponibles en la China continental, sin depender de nodos prohibidos ni de proveedores vetados. Sobre esa base, la compañía propone tres vectores para competir con Nvidia a escala de sistema: interconexión (UnifiedBus y SuperPoD Interconnect), agregación (Atlas 950/960 y SuperClusters) y disponibilidad como servicio (AI Token Service en Huawei Cloud).

En ese marco, la promesa de Xu resume el enfoque: “Los SuperPoDs y SuperClusters con tecnología UnifiedBus son nuestra respuesta a la creciente demanda de computación, tanto hoy como en el futuro”. El éxito dependerá, en última instancia, de la capacidad de Huawei para convertir ese diseño en disponibilidad real y sostenida de cómputo de IA para empresas, administraciones y laboratorios en China, en un momento en el que la demanda por entrenar y servir modelos no deja de crecer.