Los de Cupertino celebrarán a principios de junio su encuentro de desarrolladores WWDC en la que presenta novedades centradas en hardware y software y en la que se espera, como gran anuncio, la presentación de las gafas de realidad mixta de Apple que llegarán acompañadas del sistema operativo xrOS que han registrado.

Sin embargo, antes del encuentro, Apple está avanzando con cuentagotas algunas novedades, como la disponibilidad de Final Cut y Logic Pro para iPad, y el reciente anuncio que anticipa alguna de las cosas que se verán en este evento. Se trata de una serie de actualizaciones basadas en los avances en hardware y software, incluyendo machine learning, para garantizar la privacidad del usuario y mejorar la accesibilidad de los productos.

"Siempre hemos creído que la mejor tecnología es la tecnología construida para todos"

"En Apple, siempre hemos creído que la mejor tecnología es la tecnología construida para todos", asegura Tim Cook, CEO de Apple. "Hoy, estamos encantados de compartir nuevas e increíbles características que se basan en nuestra larga historia de hacer que la tecnología sea accesible, para que todo el mundo tenga la oportunidad de crear, comunicarse y hacer lo que les gusta", apunta Cook.

A finales de 2023, los usuarios de iPhone y de iPad con discapacidades cognitivas podrán utilizar estos dispositivos con mayor facilidad e independencia a través de Assistive Access, además las personas que no pueden hablar podrán teclear durante las llamadas y conversaciones con Live Speech y aquellos en riesgo de perder la capacidad de hablar podrán utilizar Personal Voice para crear una voz sintetizada que suene como ellos. Asimismo, para los usuarios con baja o nula visión, el Modo Detección de la Lupa ofrece la función de Apuntar y Hablar, que identifica el texto hacia el que apuntan los usuarios y lo lee en voz alta para ayudarles a interactuar con objetos físicos.

Apple y Google se alían para combatir el mal uso de dispositivos de rastreo Bluetooth

Leer más

Assistive Access

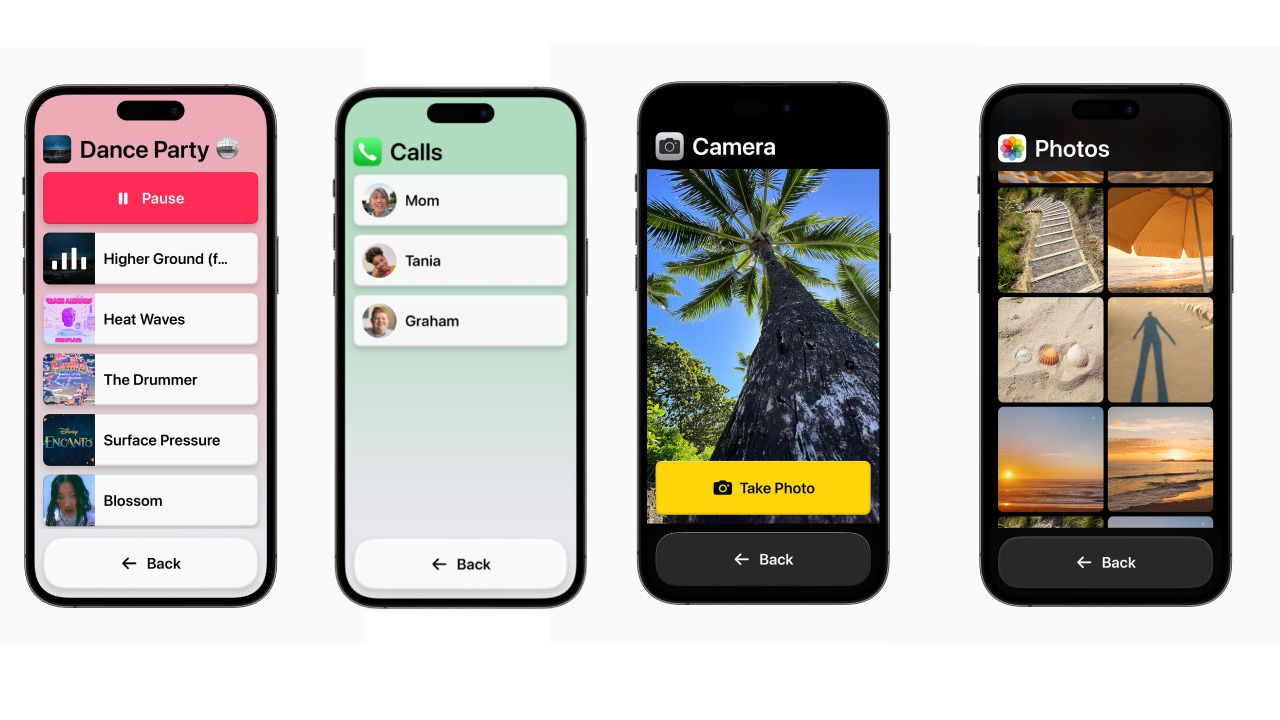

La solución Assistive Access reduce las aplicaciones y experiencias a sus características esenciales para aligerar la carga cognitiva, centrándose en las actividades clave. Para ello se han desarrollado experiencias personalizadas para Teléfono y FaceTime, que se han unificado en una única app, Llamadas, así como para Mensajes, Cámara, Fotos y Música.

Para ello se ha diseñado interfaz distinta con botones de alto contraste y etiquetas de texto grandes, así como una herramienta para ayudar a los usuarios de confianza a adaptar la experiencia a la persona a la que prestan asistencia.

Live Speech

Por su parte, Live Speech llegará a iPhone, iPad y Mac, permitiendo escribir lo que quieren decir los usuarios para que se pronuncie en voz alta durante las llamadas de teléfono y las videollamadas por FaceTime, así como también en conversaciones en persona. Además, los usuarios podrán guardar frases de uso común para intervenir rápidamente en conversaciones.

Asimismo, para aquellas personas que están en riesgos de perder la capacidad de habla, Apple ha desarrollado Personal Voice, una manera sencilla de crear una voz que suene como ellos.

Esta solución permite crear una voz personal para lo cual simplemente hay que leer un conjunto aleatorio de instrucciones de texto para grabar 15 minutos de audio en el iPhone o el iPad, y empleando aprendizaje automático se integrará con Live Speech para que los usuarios puedan hablar con su propia voz cuando se conectan con sus seres queridos.

'Señalar y hablar'

Para los usuarios ciegos o con baja visión, Apple ha desarrollado la función 'Señalar y hablar' que se integra en el modo de detección de la lupa, facilitando la interacción con objetos físicos que tienen varias etiquetas de texto. Para ello, la función combina la información de la cámara, el escáner LiDAR y el machine learning del propio dispositivo para anunciar el texto de cada etiqueta a medida que los usuarios mueven el dedo por el teclado.

La función se integra también en la app Magnifier para iPhone y para iPad, funcionando con VoiceOver y es compatible con otras funciones de Magnifier, como detección de personas, puertas y descripción de imágenes.